O Instituto Nacional de Padrões e Tecnologia (NIST) apresentou uma iniciativa abrangente para enfrentar os crescentes desafios de segurança cibernética associados aos sistemas de inteligência artificial através da liberação de um novo artigo conceitual e do plano de ação proposto para o desenvolvimento de sobreposições de controle NIST SP 800-53, projetadas especificamente para a segurança de sistemas de IA.

Nova estrutura aborda lacunas críticas de segurança de IA

O artigo conceitual representa a resposta do NIST à necessidade urgente de controles padronizados de segurança cibernética como Tecnologias de IA Torne -se cada vez mais integrado às operações críticas de infraestrutura e negócios.

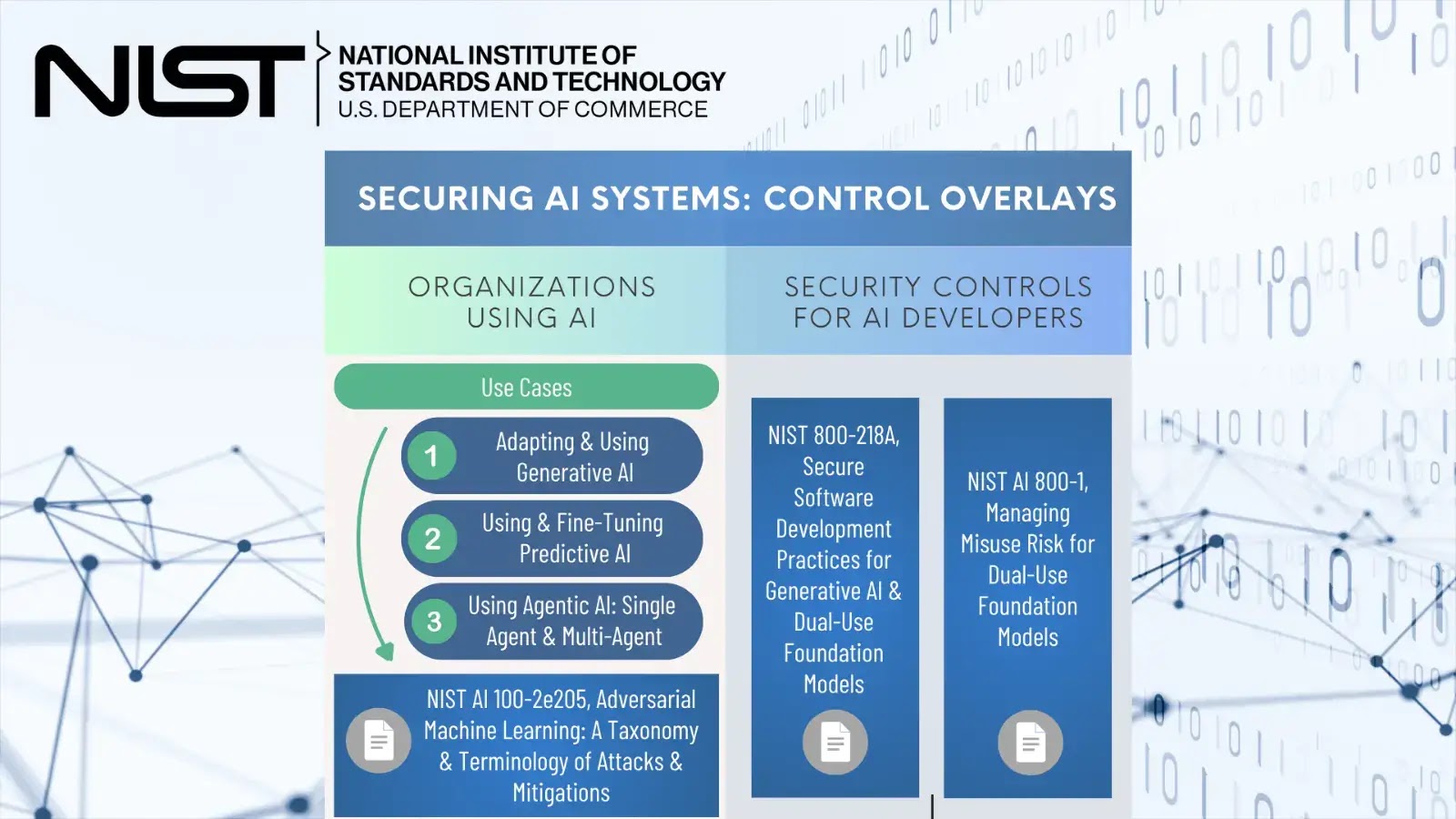

As sobreposições de controle propostas se basearão na estrutura de controle de segurança SP 800-53 estabelecida da NIST, estendendo sua metodologia comprovada para abordar os riscos exclusivos apresentados pelos sistemas de IA.

A iniciativa tem como alvo vários cenários de implantação de IA, incluindo aplicativos generativos de IA que criam conteúdo, sistemas preditivos de IA usados para tomada de decisão e arquiteturas de IA simples e multi-agentes.

Além disso, a estrutura aborda controles específicos para desenvolvedores de IA, reconhecendo que a segurança deve ser incorporada ao longo do ciclo de vida do desenvolvimento da IA, em vez de ser tratada como uma reflexão tardia.

Nist tem lançado Um canal de folga dedicado intitulado “Sobreposições do NIST para proteger a IA (#nist-overlays-segurando-AI)” para facilitar o envolvimento da comunidade e o desenvolvimento colaborativo desses controles críticos de segurança.

Essa plataforma permite que as partes interessadas de toda a segurança cibernética e das comunidades de IA contribuam com seus conhecimentos, participem de discussões facilitadas com os principais investigadores da NIST e forneçam feedback em tempo real sobre a estrutura em evolução.

A abordagem colaborativa reflete o reconhecimento da NIST que garantir os sistemas de IA requer informações de diversas perspectivas, incluindo pesquisadores de segurança, desenvolvedores de IA, administradores de sistemas e profissionais de gerenciamento de riscos.

Por meio do canal Slack, os participantes podem acessar atualizações regulares, se envolver em discussões técnicas e ajudar a moldar as sobreposições de controle final com base nas experiências de implementação do mundo real.

O momento desta iniciativa coincide com o crescente reconhecimento de vulnerabilidades de segurança específicas da IA, incluindo Ataques de injeção imediataenvenenamento por modelo, exfiltração de dados através de interfaces de IA e ataques adversários projetados para manipular os processos de tomada de decisão da IA.

As estruturas tradicionais de segurança cibernética geralmente ficam aquém ao abordar esses novos vetores de ataque, criando uma necessidade premente de controles especializados.

As sobreposições propostas complementarão a estrutura do NIST existente como a estrutura de gerenciamento de risco de IA (AI RMF 1.0), fornecendo controles de segurança acionáveis que as organizações podem implementar para proteger suas implantações de IA.

Essa iniciativa representa um passo significativo no estabelecimento de abordagens padronizadas para a segurança cibernética da IA, potencialmente influenciando como as organizações em todo o mundo abordam os desafios de segurança da implementação da IA.

Encontre esta notícia interessante! Siga -nosGoogle NewsAssim,LinkedIneXPara obter atualizações instantâneas!